- ASIC

- 电池管理 IC

- 时钟和时序解决方案

- ESD 和浪涌保护器件

- 汽车以太网

- 评估板

- 高可靠性

- 隔离

- 存储器

- 微控制器

- 功率产品

- 射频

- 安全智能卡解决方案

- 传感器技术

- 小信号晶体管和二极管

- 收发器

- 通用串行总线(USB)

- 无线连接

- 英飞凌大中华区生态圈

- 搜索工具

- 技术

- 封装

- 订单

- 概览

- 嵌入式闪存eFlash IP 解决方案

- RAM和Flash多芯片封装MCP解决方案

- F-RAM铁电存储器

- NOR 闪存

- nvsRAM非易失性存储器

- PSRAM伪静态随机存储器

- 抗辐射和高可靠性的存储器

- SRAM静态随机存储器

- 晶圆和裸片存储器解决方案

- 概览

- AC-DC电源转换

- 电动汽车动力系统

- D 类音频放大器 IC

- 非接触式电源和检测 IC

- DC-DC 转换器

- 二极管&晶闸管 (Si/SiC)

- 氮化镓(GaN)

- GaN EiceDRIVER™高速栅极驱动器

- IGBT 产品及驱动器件

- 智能功率模块(IPM)

- LED 驱动芯片

- 电动机驱动器

- 高效能功率MOSFET 和 MOS管

- 功率模块

- 电源模块

- 保护和监控IC

- 碳化硅 (SiC)

- 智能电源开关

- 固态继电器

- 无线充电 IC

- 概览

- Calypso® 产品

- CIPURSE™ 产品

- 非接触式存储

- 了解 OPTIGA™ 嵌入式加密解决方案

- SECORA™ 安全解决方案

- 安全控制器

- 智能卡模块

- 政府身份证的智能解决方案

- 概览

- USB 2.0 外设控制器

- USB 3.2 外设控制器

- USB 集线器控制器

- USB PD 高压微控制器

- USB-C AC-DC 和 DC-DC 充电解决方案

- USB-C 充电端口控制器

- USB-C 供电控制器

- 概览

- AIROC™ 车载无线

- AIROC™ 蓝牙Bluetooth® 和多协议解决方案

- AIROC™ 互联微控制器

- AIROC™ Wi-Fi + Bluetooth® 组合

- 概览

- FM0+ 32 位 Arm® Cortex-M0®+ 微控制器 (MCU) 系列

-

FM3 32 位 Arm® Cortex-M3® 微控制器 (MCU) 系列

- 概览

- FM3 CY9AFx1xK 系列 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9AFx1xL/M/N 系列 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9AFx2xK/L 系列 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9AFx3xK/L 系列超低漏电流 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9AFx4xL/M/N 系列低功耗 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9AFx5xM/N/R 系列低功耗 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9AFxAxL/M/N 系列超低漏电流 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9BFx1xN/R 高性能系列 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9BFx1xS/T 高性能系列 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9BFx2xJ 系列 Arm® Cortex-M3®微控制器 (MCU)

- FM3 CY9BFx2xK/L/M 系列 Arm® Cortex-M3® 微控制器 (MCU)

- FM3 CY9BFx2xS/T 系列 Arm® Cortex-M3® 微控制器 (MCU)

- FM4 32 位 Arm® Cortex-M4® 微控制器 (MCU) 系列

- 概览

-

TriCore™ AURIX™ TC2x安全模块

- 概览

- AURIX™系列 – TC21xL

- AURIX™ 系列 – TC21xSC (无线充电)

- AURIX™ 系列 – TC22xL

- AURIX™系列 – TC23xL

- AURIX™ 系列 – TC23xLA (ADAS)

- AURIX™ 系列 – TC23xLX

- AURIX™ 系列 – TC264DA (ADAS)

- AURIX™系列 – TC26xD

- AURIX™ 系列 – TC27xT

- AURIX™ 系列 – TC297TA (ADAS)

- AURIX™ 系列 – TC29xT

- AURIX™ 系列 – TC29xTT (ADAS)

- AURIX™系列 – TC29xTX

- AURIX™ TC2x仿真器件

- 32 位TriCore™ AURIX™ – TC3x

- 32 位TriCore™ AURIX™ - TC4x

- 概览

- PSOC™ 4 Arm® Cortex® -M0/M0+

- PSOC™ 4 HV Arm® Cortex® -M0+

- PSOC™ 5 LP Arm® Cortex® -M3

- PSOC™ 6 Arm® Cortex-M4®/M0+

- PSOC™ Multitouch Touchscreen Controller

- PSOC™ Control C3 Arm® Cortex®-M33

- PSOC™ Automotive 4: Arm® Cortex®-M0/M0+

- PSOC™ Edge Arm® Cortex® M55/M33

- 概览

- 32 位 TRAVEO™ T2G Arm® Cortex®用于车身电子应用

- 用于仪表盘的 32 位 TRAVEO™ T2G Arm® Cortex®

- 概览

- 32 位XMC1000工业微控制器 Arm® Cortex-M0®

- 32 位XMC4000工业微控制器 Arm® Cortex-M4®

- XMC5000 Industrial Microcontroller Arm® Cortex®-M4F

- 32 位XMC7000工业微控制器 Arm® Cortex-M7®

- 概览

- 桥式整流器和交流开关

- CoolSiC™ 肖特基二极管

- 二极管裸片

- 硅二极管

- 晶闸管/二极管模块

- 晶闸管软启动器模块

- 晶闸管/二极管盘

- 概览

- BLDC 电机驱动器

- BDC电机驱动器

- 步进电机和伺服电机驱动器

- 带MCU的电机驱动器

- 使用 MOSFET 的桥式驱动器

- Gate driver ICs

- 概览

- 汽车级MOSFET

- 双 MOSFET

- MOSFET(Si 和 SiC)模块

- N 沟道耗尽型 MOSFET

- N 沟道 MOSFET

- P 沟道 MOSFET

- 碳化硅 CoolSiC™ MOSFET

- 250V至600V G14小信号MOS

- 概览

- OPTIGA™ Authenticate

- OPTIGA™ Authenticate NFC 解决方案

- OPTIGA™ Connect – 交钥匙式 eSIM 安全解决方案

- OPTIGA™ Trust

- OPTIGA™ 可信平台模块 (TPM)

- 概览

- EZ-PD™ ACG1F 单端口 USB-C 控制器

- EZ-PD™ CCG2 USB Type-C 端口控制器

- EZ-PD™ CCG3PA Automotive USB-C 和 Power Delivery 控制器

- EZ-PD™ CCG4 双端口 USB-C 和 PD

- EZ-PD™ CCG5 双端口和 CCG5C 单端口 USB-C PD 控制器

- EZ-PD™ CCG6 单端口 USB-C & PD 控制器

- EZ-PD ™ CCG6_CFP 和 EZ-PD ™ CCG8_CFP 双单端口 USB-C PD

- EZ-PD™ CCG6DF 双端口和 CCG6SF 单端口 USB-C PD 控制器

- EZ-PD™ CCG7D 汽车双口 USB-C PD + DC-DC 控制器

- EZ-PD™ CCG7S 汽车单口 USB-C PD 解决方案,配备DC-DC控制器

- EZ-PD™ CCG7SAF 车规级单端口 USB-C PD + DC-DC 控制器 + FETs

- EZ-PD™ CCG8 双/单口 USB-C PD

- EZ-PD™ CMG1 USB-C EMCA 控制器

- 支持 EPR 的 EZ-PD™ CMG2 USB-C EMCA 控制器

- 最新动态

- 航空航天

- 智能汽车解决方案

- 消费类电子产品

- 健康和 生活方式

- 家用电器

- 工业

- 信息和通信技术

- 可再生能源

- 机器人

- 安全解决方案

- 智能家居和楼宇

- 解决方案

- 概览

- 电源适配器和充电器

- 适用于智能电视的完整系统解决方案

- 移动设备和智能手机解决方案

- 多旋翼飞机和无人机

- 电动工具

- 家庭娱乐应用的半导体解决方案

- 智能会议系统

- 概览

- 汽车辅助系统

- 车载网关

- 汽车pds配电系统

- 车身控制模块 (BCM)

- 舒适便捷电子产品

- 区域 DC-DC 转换器 48 V-12 V

- 区域控制器

- 最新动态

- 概览

- AIROC™ 软件&工具

- AURIX™应用软件

- DRIVECORE 用于汽车软件开发

- iMOTION™ 工具和软件

- Infineon智能功率开关和栅极驱动器工具套件

- MOTIX 软件&工具

- OPTIGA™工具和软件

- PSOC™ 软件&工具

- TRAVEO™ 软件&工具

- XENSIV™ 工具和软件

- XMC™ 工具和软件

- 概览

- EZ-PD™ CCGx Dock 软件开发工具包

- FMx Softune IDE

- ModusToolbox™ 软件

- PSOC™ Creator软件

- 雷达开发套件

- 锈

- USB 集线器控制器

- 无线连接蓝牙网状网络辅助应用程序

- XMC™ DAVE™ 软件

- 最新动态

- 支持

- 培训

- 英飞凌开发者社区

- 最新消息

商业财经新闻

16/02/2026

商业财经新闻

10/02/2026

季度报告

04/02/2026

商业财经新闻

03/02/2026

- 公司名称

- 我们的故事

- 活动资讯

- 新闻中心

- 投资者

- 职业生涯

- 质量

- 最新消息

商业财经新闻

16/02/2026

商业财经新闻

10/02/2026

季度报告

04/02/2026

商业财经新闻

03/02/2026

人工智能在现代技术中的作用具有变革意义,其发展在根本上依赖于半导体技术的支持。半导体是人工智能的核心,能够驱动、收集、处理并管理系统运行所需的大量数据。从基础运算到让AI“从数据中学习”的复杂机器学习任务,都离不开半导体。

自 2010 年以来,全球每年产生的数据量逐年增长,最初的规模仅为 2 ZB。到 2025 年,这一数字预计将激增至175 ZB——短短15年增长了145倍。

数据是人工智能的命脉,其重要性不言而喻。事实上,人工智能,尤其是机器学习的模型训练严重依赖大量数据,这些数据可以涵盖多种格式,包括文本文档、图像和温度和湿度等传感器读取的数据。通过分析这些数据,AI系统可以识别模式和关联,然后利用这些数据进行预测、决策与内容生成。用于训练AI系统的数据类型与开发人工智能的具体任务密切相关。例如,文本生成 AI 系统(如大型语言模型)需要大量文本数据才能有效运行,而围绕道路交通的预测分析可能依赖传感器采集的数据来做出准确的预测。最终,数据的质量和数量直接影响AI系统的准确性、可靠性和性能。

数据中心作为人工智能的算力基石发挥着关键作用。他们必须全天候地处理海量的数据流。我们看到,人工智能,尤其是生成性人工智能,将加速数据增长,而这种不断增长的数据需求需要无缝连接、更高的带宽、广域覆盖和强大的计算能力。

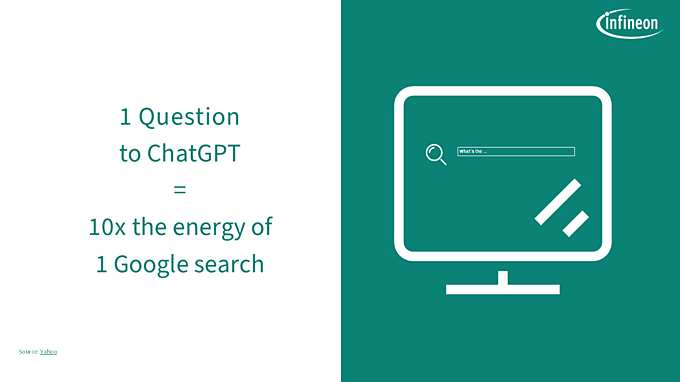

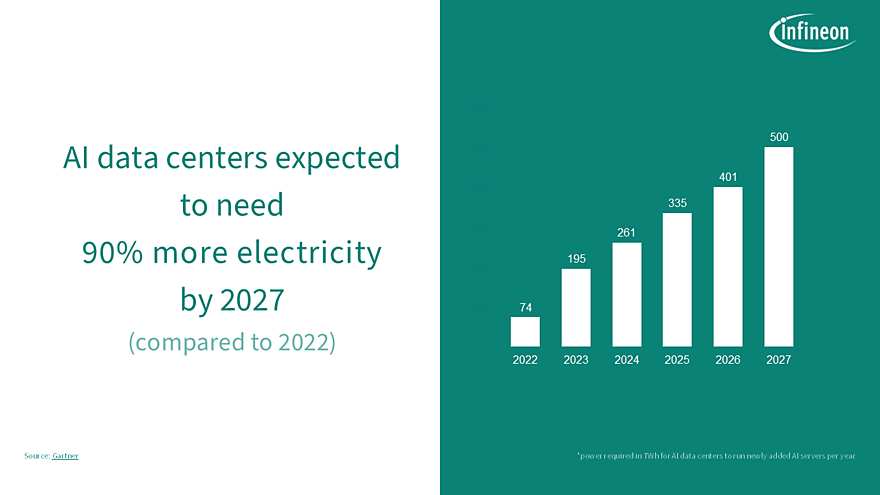

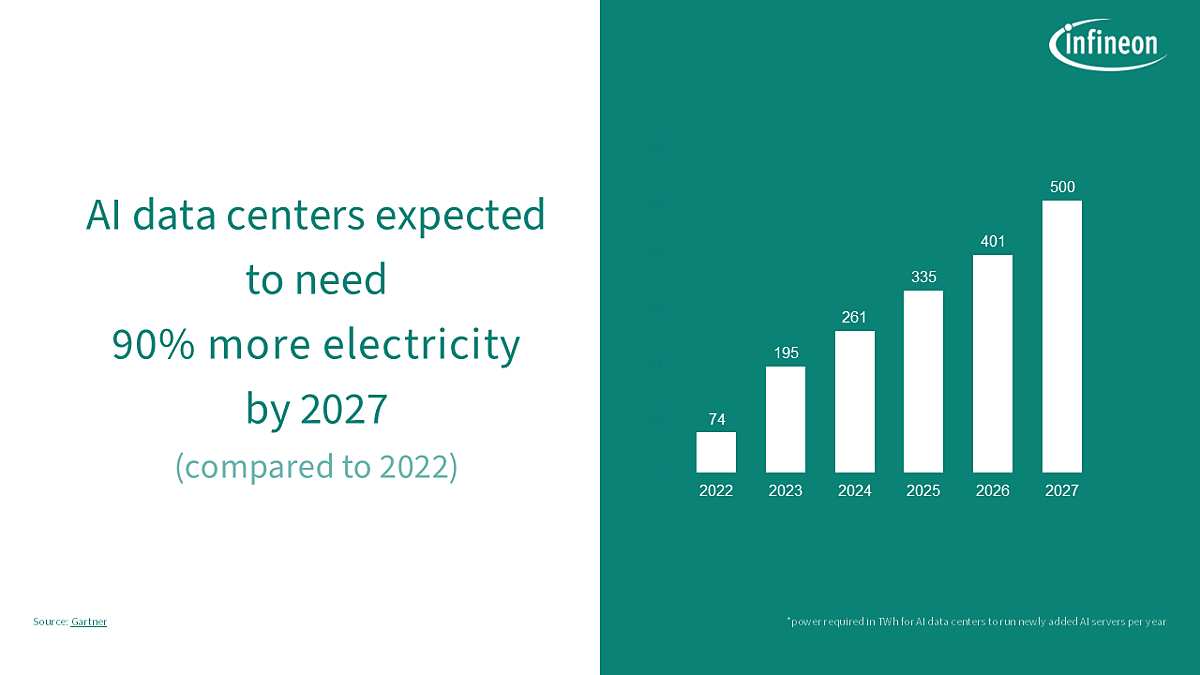

人工智能 (AI) 应用的快速发展大大增加了数据中心的电力需求。训练和运行AI模型之所以需要消耗能源,是因为机器学习算法的复杂计算需要算力支撑。自 2012 年以来,训练现代AI模型所需的计算能力大约每 3.4 个月翻一番。算力需求的指数级增长直接反映在更高的电力需求上,并增加了网络的总体负载。计算越复杂,耗电量越大。这不仅涉及处理器本身消耗的用电量,还包括配套的基础设施,包括制冷系统和供电网络。

在2025 年 4 月发布的最新《能源和AI报告》中,“Lift-Off ”轨迹模型预测显示,到 2035 年,全球数据中心及其必要基础设施的电力需求将超过 1700 TWh。与 2022 年的约 460 TWh(约占全球电力需求的 2%)相比,这一数字在 13 年内增长了 370%。

简而言之,没有电力支撑,就没有AI。

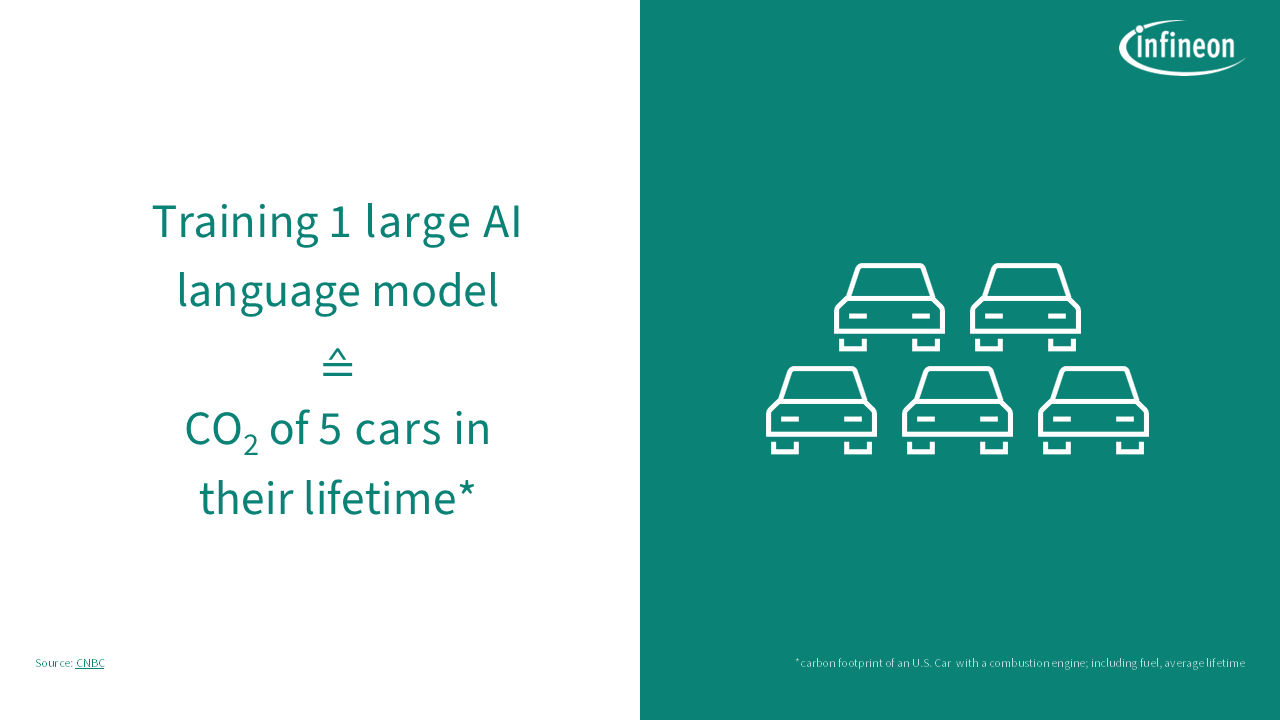

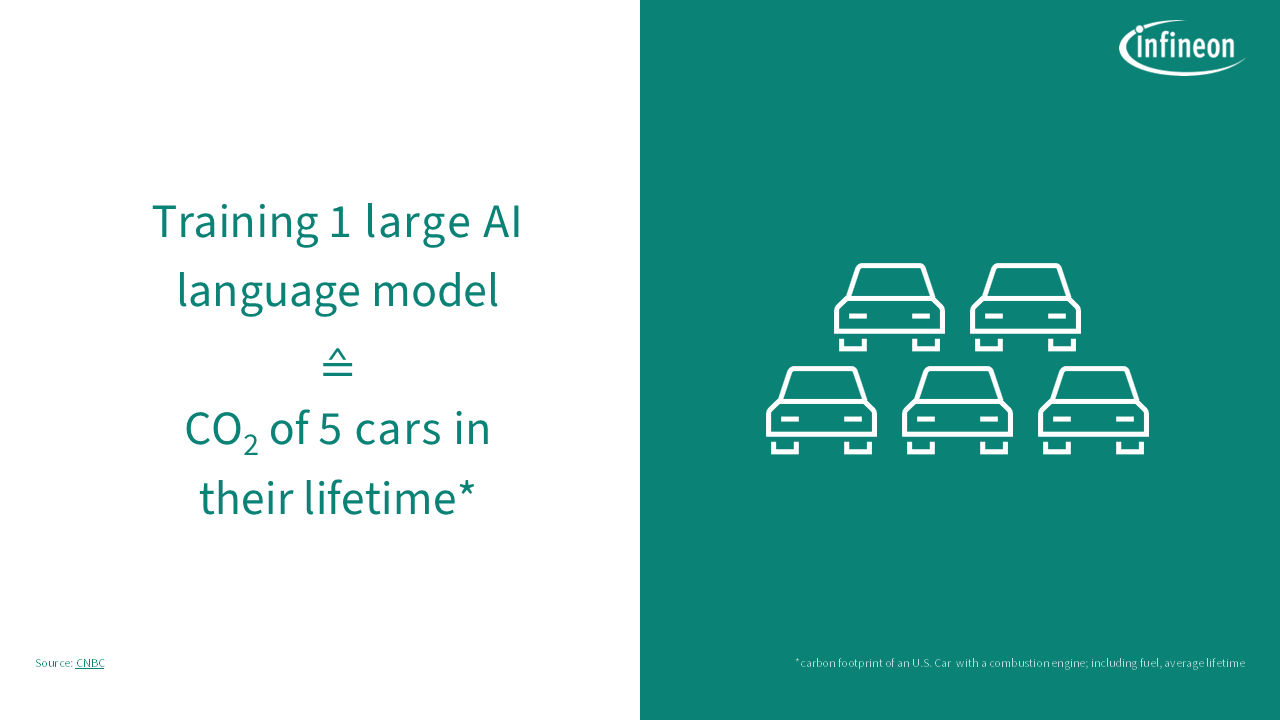

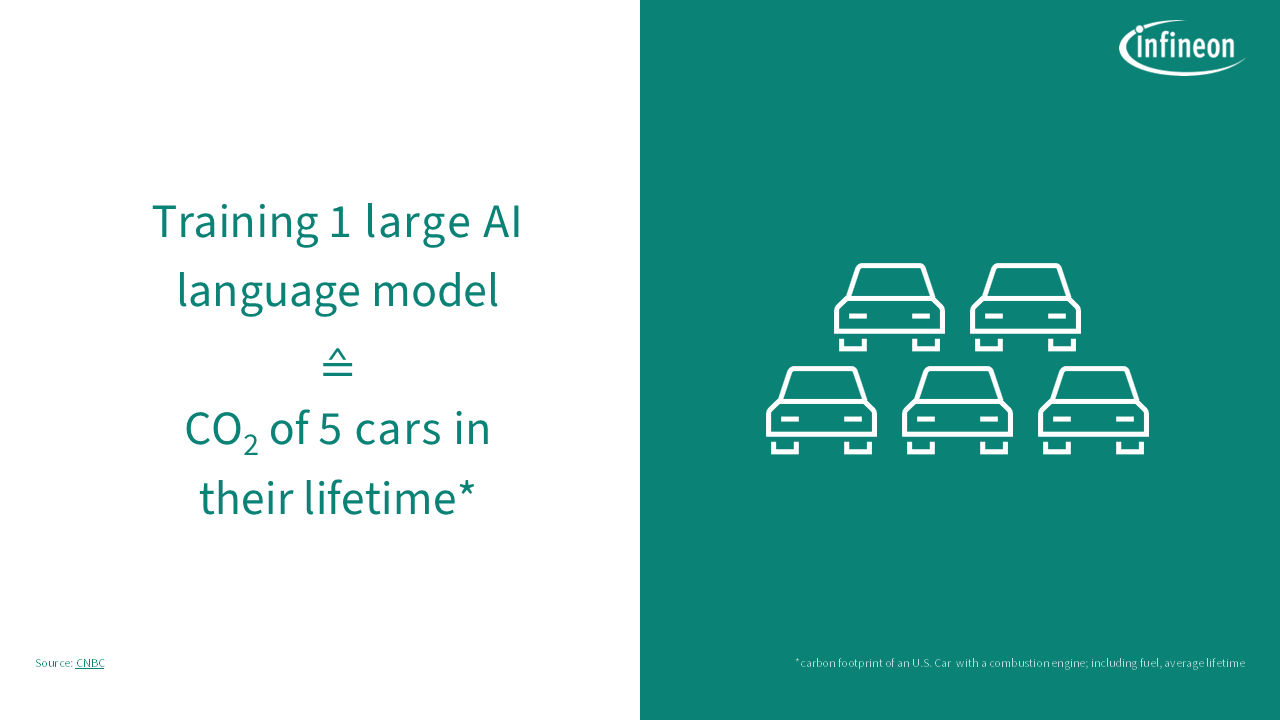

在人工智能热潮的背后, 是一个计算密集、耗能巨大的过程,它带来了惊人的碳足迹。在拓展AI能力的同时,我们需要意识到其数据中心巨大的能源消耗,这些能源往往来自不可再生资源。此外,AI数据中心需要大量的冷却机制来防止过热,这通常会导致大量的水资源消耗。用于冷却这些大型数据中心的耗水量堪比小型城镇,这给当地的水资源带来了额外的压力。

鉴于这些情况,我们必须注重提高能源效率。例如,这意味着开发更高效的AI算法或通过实施创新、节能的电源管理解决方案来优化数据中心基础设施,从而显著减少电力输送过程中产生的损耗。唯有克服这些挑战,才能在实现环境可持续性的同时,确保AI技术规模化发展的经济可行性。

针对这一新挑战,有很多可行的解决方案。关键在于:解决方案必须覆盖从进入数据中心的电网到核心 AI 处理器(从电网到核心)的能源转换。

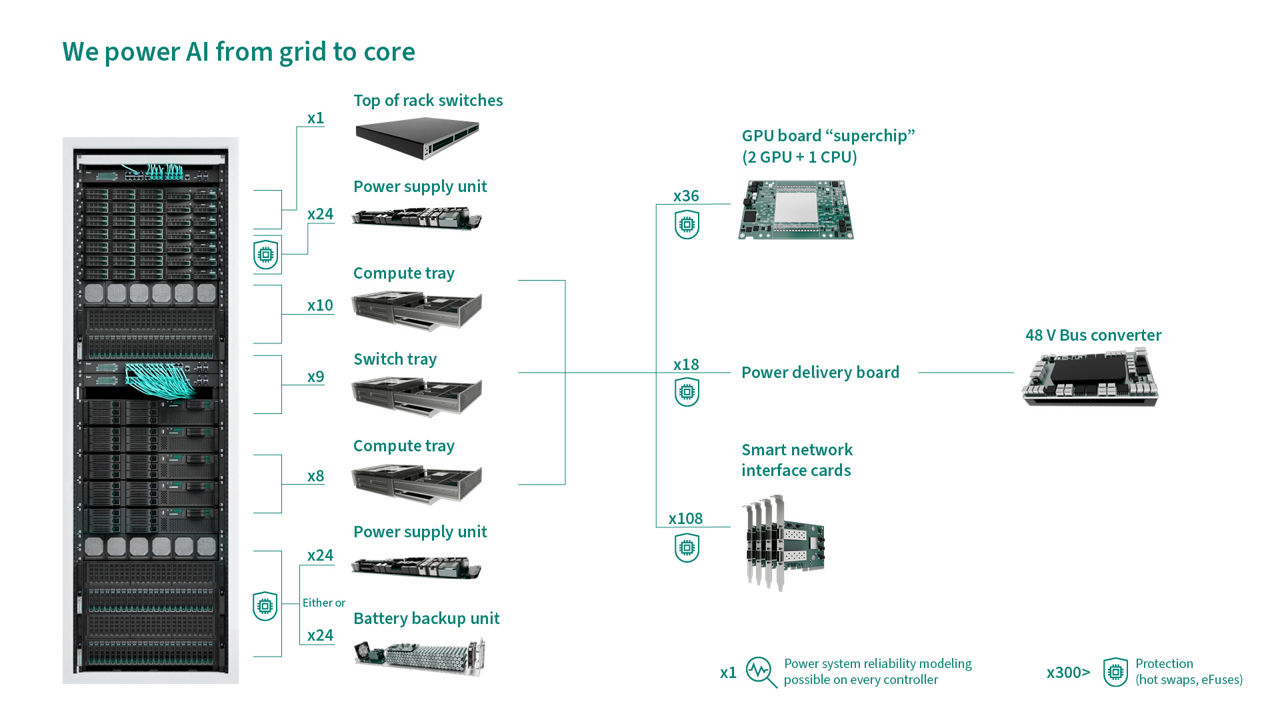

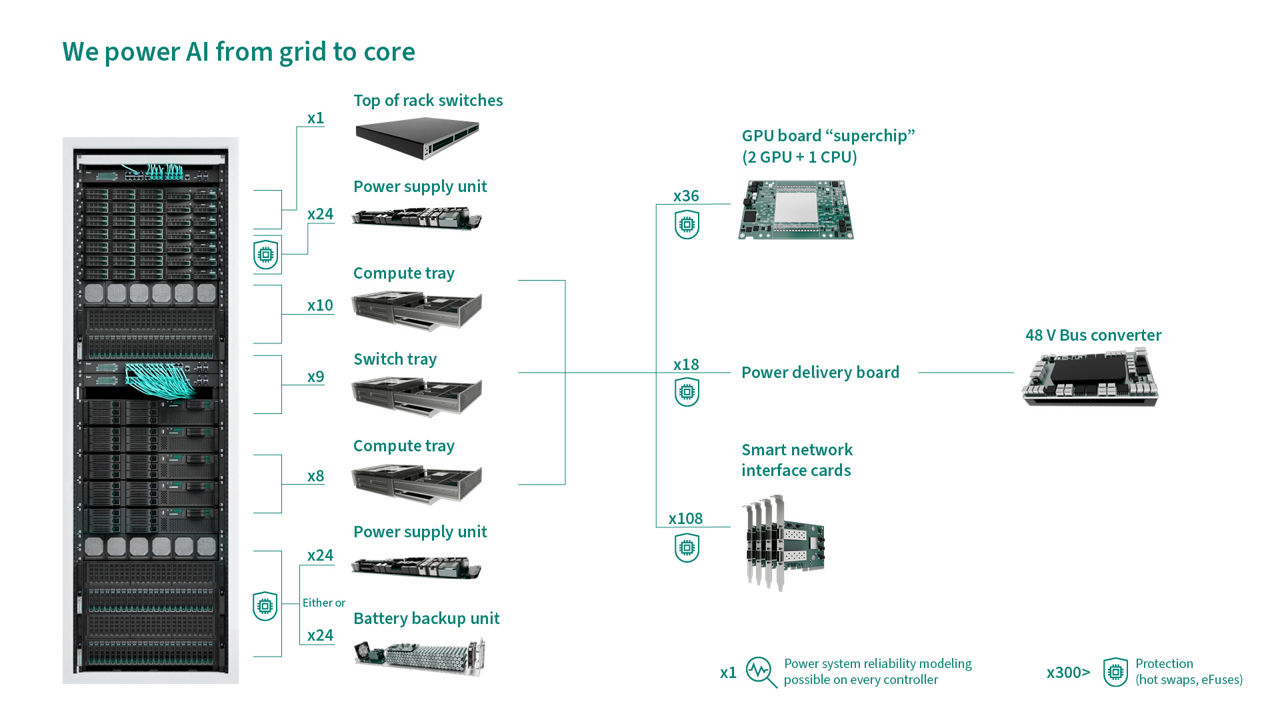

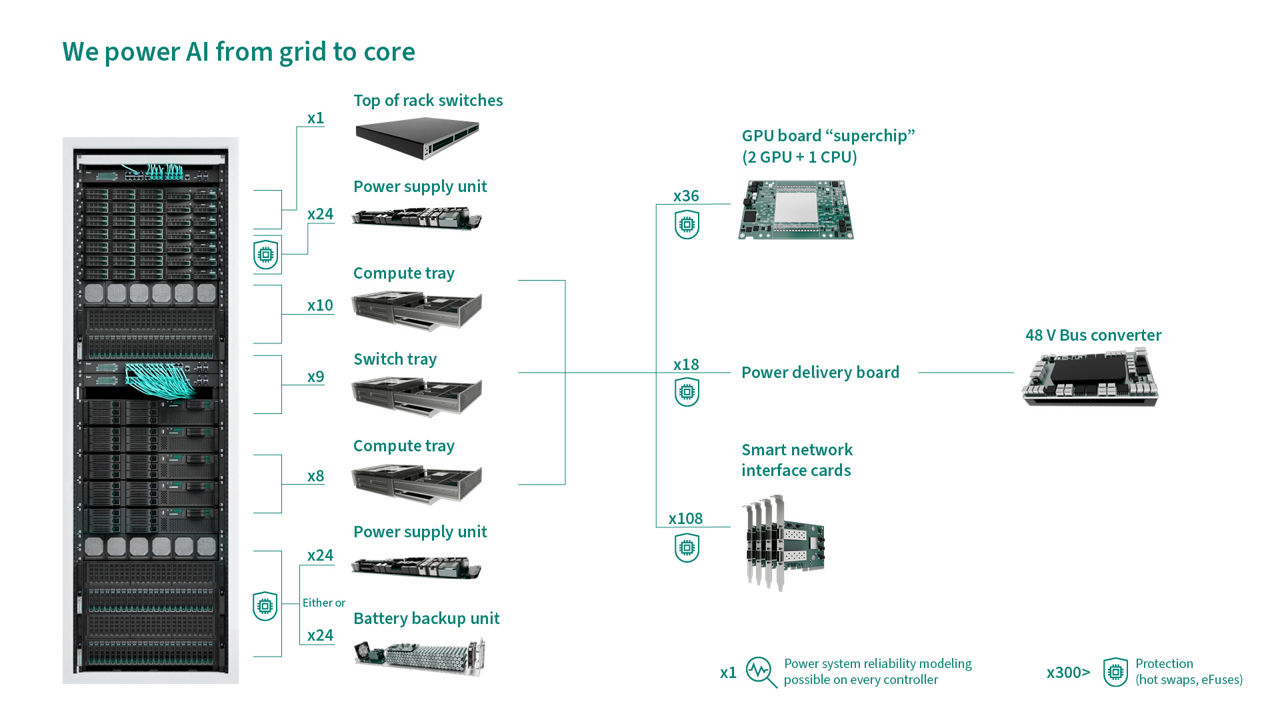

英飞凌的创新功率半导体产品组合覆盖从电网到核心的全栈式解决方案,并利用硅(Si)、碳化硅(SiC)与氮化镓(GaN)的优势实现最高的效率、功率密度和稳健性。典型的应用场景包括:架顶式交换机、电源装置、电池备用装置、DC-DC 电路和计算(如 48 V 中间总线转换器、电源模块和分立解决方案)和保护装置。此外,借助我们创新的功率系统可靠性建模解决方案,数据中心可以最大限度地提高电源稳定性和正常运行时间,通过动态系统参数记录实时监控电源健康状况。

在全球范围内,使用各种类型的先进功率半导体可以节省约 48 TWh 的电力。英飞凌分析显示,这相当于减少了超过2200万吨的二氧化碳排放。

展望未来,我们需要应对许多技术挑战,同时不断提高能效和性能。我们需要为AI数据中心提供环保、稳定可靠的能源。这关乎如何在承担环保责任的前提下,推动人工智能技术实现可持续增长。毕竟,没有电力支撑,就没有AI。这一现实鞭策我们不断推进技术进步,确保在AI不断发展的同时,我们为其提供的高效、可靠的供电解决方案也与之同步演进。